LangChain开发LLM应用,3种运行方式

LangChain开发LLM应用时,需要机器部署GLM。很多同学都被第一步吓到了,那么如何绕过这一步,先学习LLM模式的应用呢? Langchain要快速启动吗?本视频介绍了启动LangChain的3种方式。如有错误,请指正。

Langchain 官方文档地址:https://python.langchain.com/

基本功能

LLM调用

- 支持 OpenAI、Hugging...Fake Kong 等多种 Azure 模型接口,用于测试缓存支持

- 如 in-mem(内存)、SQLite、Redis、SQL

- 使用记录

- 支持流式模式(即逐字返回,类似打字效果)

提示管理,支持各种自定义模板

拥有大量文档加载器如Email、Markdown、PDF、Youtube...

索引支持

- 文档分割器

- 对接Chroma、Pinecone等矢量存储和搜索。如何测试Langchain 项目:

1 使用 Langchian 的 FakeList LLM

为了节省时间,直接输入代码 在这里 Mock 并下载 ChatGPT,使用 mockLLm

#from langchain.llms import OpenAI from langchain.llms.fake import FakeListLLM os.environ["OPENAI_API_KEY"] = config('OPENAI_API_KEY')REPL 代表“Read–Eval–Print Loop”( read-evaluate-print-loop),这是一个简单的交互式编程环境。

在REPL环境中,用户可以输入一个或多个编程命令,系统将立即执行这些命令并打印结果。这种方法非常适合快速代码实验和调试。2 3 使用huggingface

https://huggingface.co/docs

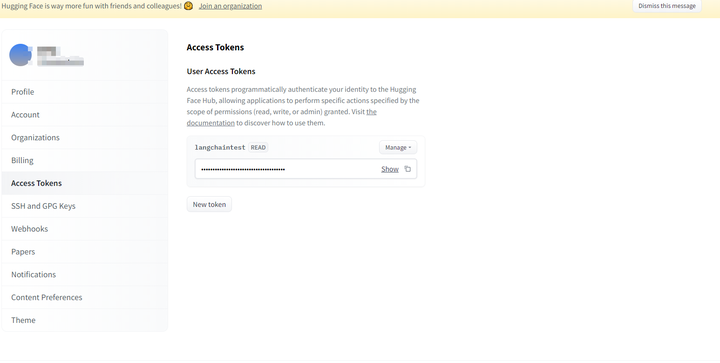

1。注册帐户

2。创建访问令牌

示例:使用模型来汇总文档

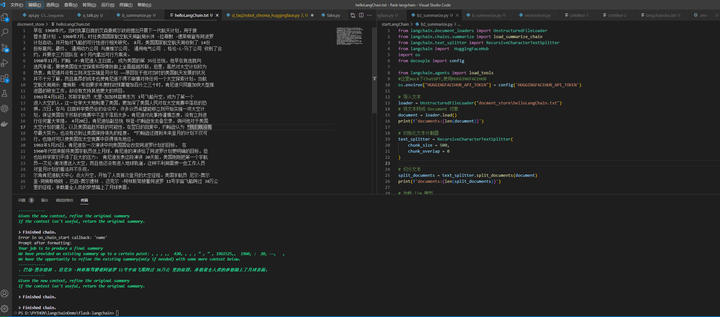

from langchain.document_loaders import UnstructuredFileLoader from langchain.chains.summarize import load_summarize_chain from langchain.text_splitter import RecursiveCharacterTextSplitter from langchain import HuggingFaceHub import os from decouple import config from langchain.agents import load_tools此处模拟ChatGPT,使用HUGGINGFACEHUB

os.environ["HUGGINGFACEHUB_API_TOKEN"] = config('HUGGINGFACEHUB_API_TOKEN')文本导入

loader = UnstructuredFileLoader("docment_store\helloLangChain.txt")将分割文本转换为文档对象'初始文本'初始文本加载LLM模型

overal_temperature = 0.1 flan_t5xxl = HuggingFaceHub(repo_id="google/flan-t5-xxl", model_kwargs={"temperature":overal_temperature, "max_new_tokens":200} ) llm = flan_t5xxl tools = load_tools(["llm-math"], llm=llm)创建汇总链

chain = load_summarize_chain(llm, chain_type="refine", verbose=True)执行汇总链

chain.run(split_documents)作者:京东科技杨健

来源:京东云开发者社区

版权声明

本文仅代表作者观点,不代表Code前端网立场。

本文系作者Code前端网发表,如需转载,请注明页面地址。

上一篇:从头开始理解机器学习 下一篇:Azure OpenAI 入门指南:令牌和消息概念

code前端网

code前端网